论文

Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification

发布年份:2016

会议:ACL

作者:Peng Zhou, Wei Shi, Jun Tian, Zhenyu Qi, Bingchen Li, Hongwei Hao, Bo Xu

机构:Institute of Automation, Chinese Academy of Sciences

motivation:

- CNN 结构不适用于捕捉到长距离的特征。

- 其他的关系分类方法依赖于 NLP 工具(NER 等)或者 WordNet。

数据集:SemEval 2010 task 8 dataset,8000 个训练用例和 2717 个测试用例,随机挑选了 800 个句子作为验证集。

模型结构

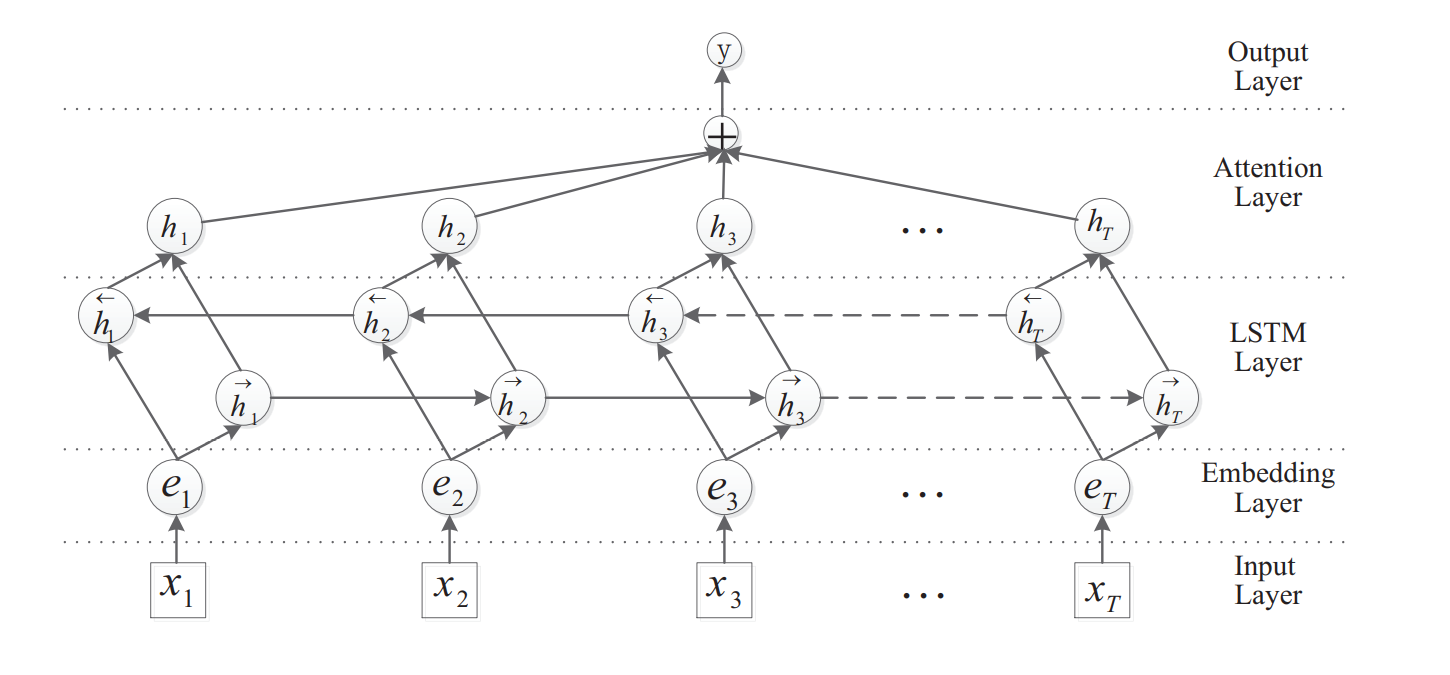

模型的结构如下所示,包括几个部分:

- Embedding Layer:将 token 转为 embedding。

- LSTM Layer:使用 BiLSTM 用于提取到 high level features。

- Attention Layer:产生一个权重向量,这个权重乘以 BiLSTM 的输出(这就是 sentence-level feature)得到 Output Layer 的输入。

- Output Layer:进行关系分类。

LSTM Layer

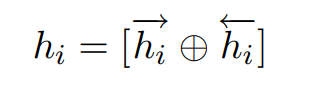

双向 LSTM 的输出拼接起来得到 hi:

Attention Layer

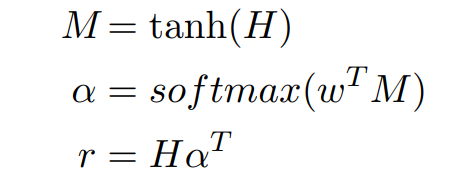

Attention 输出的结果 r 的运算方法如下:

其中,所有 BiLSTM 的输出 hi 拼接起来得到矩阵 H,α 相当于权重向量。

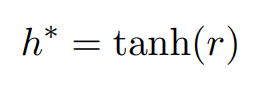

最终, 得到的 sentence-level 的feature(用于分类的输入)h*,如下所示:

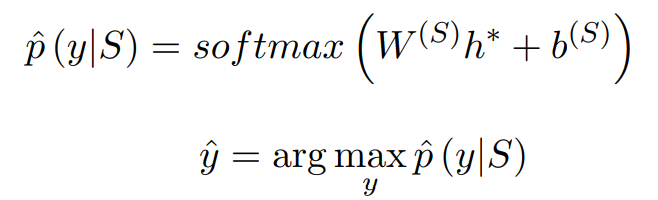

Output Layer

Output Layer 用于关系分类,在这篇文章中使用 softmax 进行关系分类:

实验结论

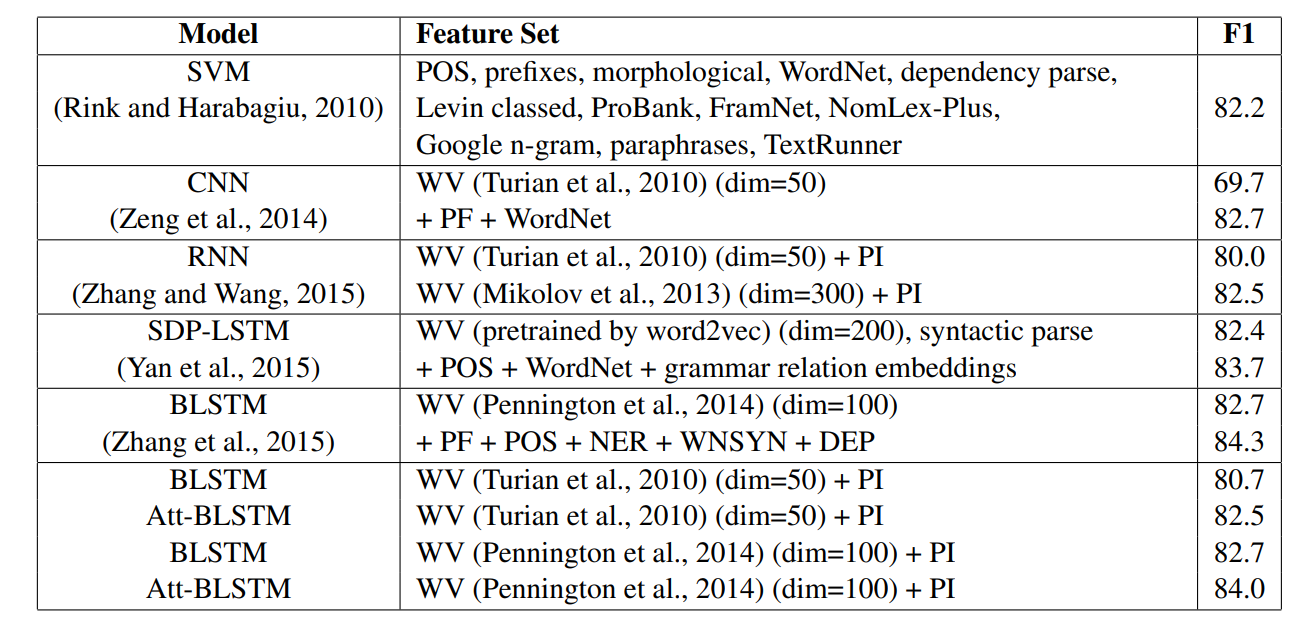

与其他方法的对吧如下: