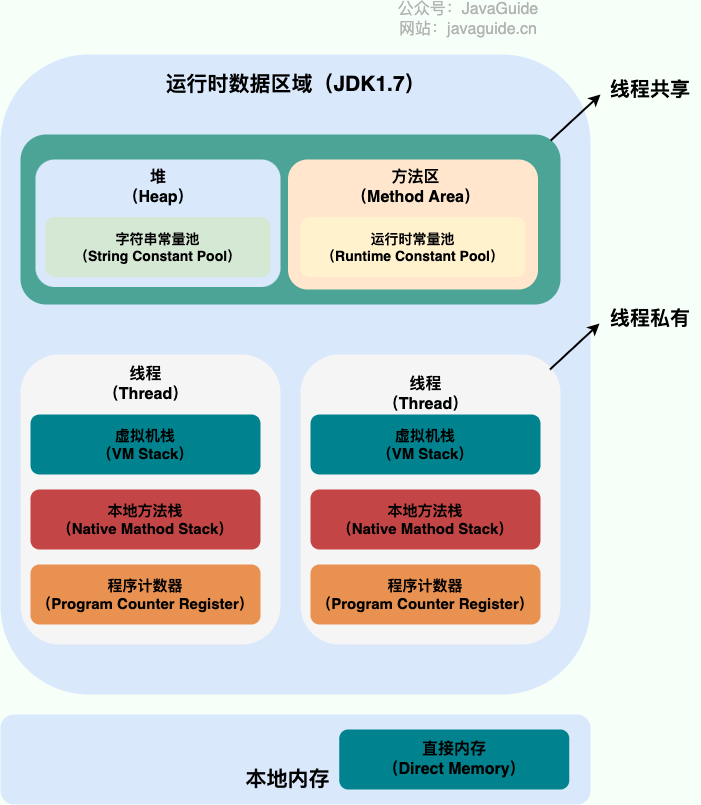

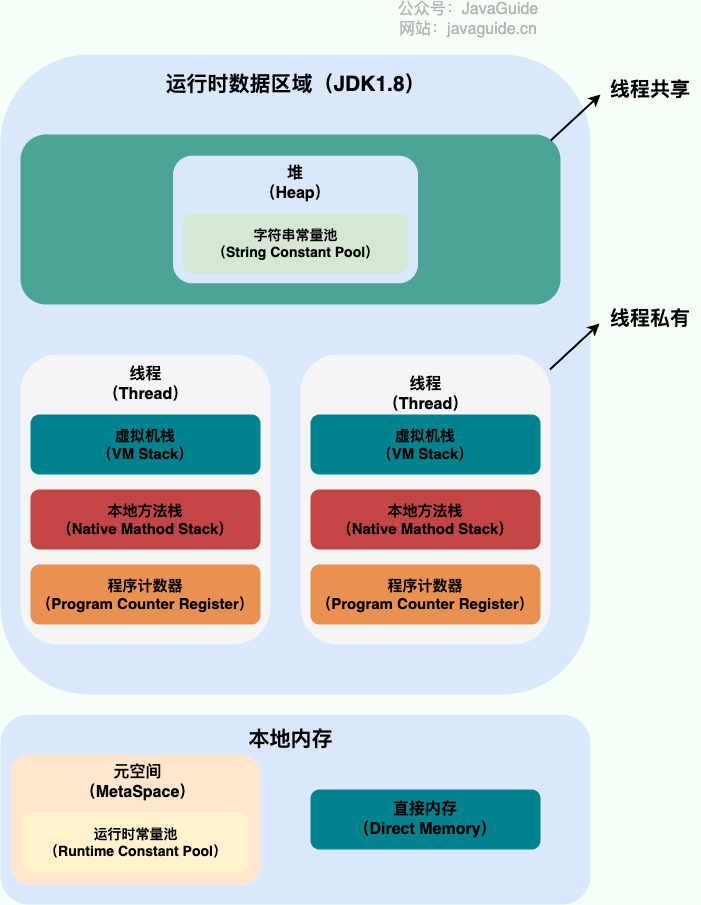

在 Java 7 以及之前,堆分为三个区域新生代(Eden、S0、S1)、老生代(Tenured)、永久代;但是从 Java 8 开始,永久代已经被元空间所代替,元空间使用的是直接内存。

垃圾回收

空间回收原则

针对 HotSpot VM 的实现,它里面的 GC 其实准确分类只有两大种:

部分收集 (Partial GC):

- 新生代收集(Minor GC / Young GC):只对新生代进行垃圾收集;

- 老年代收集(Major GC / Old GC):只对老年代进行垃圾收集。需要注意的是 Major GC 在有的语境中也用于指代整堆收集;

- 混合收集(Mixed GC):对整个新生代和部分老年代进行垃圾收集。

整堆收集 (Full GC):收集整个 Java 堆和方法区。

JVM 内存分配与空间回收有以下几个原则:

- 对象优先在 Eden 区分配。

- 大对象直接进入老年代。

- 长期存活的对象进入老年代。

- 空间分配担保。

对象优先在 Eden 分配

大多数情况下,对象在新生代中 Eden 区分配。当 Eden 区没有足够空间进行分配时,虚拟机将发起一次 Minor GC,然后在 Eden 区分配。

大对象直接进入老年代

大对象直接进入老年代的行为是由虚拟机动态决定的,它与具体使用的垃圾回收器和相关参数有关。大对象直接进入老年代是一种优化策略,旨在避免将大对象放入新生代,从而减少新生代的垃圾回收频率和成本。

- G1 垃圾回收器根据

-XX:G1HeapRegionSize参数设置的堆区域大小和-XX:G1MixedGCLiveThresholdPercent参数设置的阈值,来决定哪些对象会直接进入老年代。 - Parallel Scavenge 垃圾回收器中,默认情况下,并没有一个固定的阈值来决定何时直接在老年代分配大对象。而是由虚拟机根据当前的堆内存情况和历史数据动态决定。

长期存活的对象进入老年代

虚拟机给每一个对象一个年龄计数器,作为对象存活的年龄。大部分情况,对象都会首先在 Eden 区域分配。如果对象在 Eden 出生并经过第一次 Minor GC 后仍然存活,并且能被 Survivor 容纳的话,将被移动到 Survivor 空间(s0 或者 s1)中,并将对象年龄设为 1。

对象在 Survivor 中每熬过一次 MinorGC,年龄就增加 1 岁,当它的年龄增加到一定程度(默认为 15 岁),就会被晋升到老年代中。对象晋升到老年代的年龄阈值,可以通过参数 -XX:MaxTenuringThreshold 来设置。

Hotspot 遍历所有对象时,按照年龄从小到大对其所占用的大小进行累加,当累加到某个年龄时,所累加的大小超过了 Survivor 区的一半,则取这个年龄和

MaxTenuringThreshold中更小的一个值,作为新的晋升年龄阈值。

空间分配担保

空间分配担保是为了确保在 Minor GC 之前老年代本身还有容纳新生代所有对象的剩余空间。

只要老年代的连续空间大于新生代对象总大小或者历次晋升的平均大小,就会进行 Minor GC,否则将进行 Full GC。

死亡对象判别

死亡对象判别常用方法有:应用计数法和可达性分析。

如何判断废弃常量?

如果没有任何一个 String 对象引用一个字符串常量,那么这个字符串常量就是废弃的。

如何判断无用的类?

判断无用的类,需要满足三个条件(虚拟机可以对满足上述 3 个条件的无用类进行回收,仅仅是可以,不是一定):

- 该类的所有实例被回收。

- 加载该类的 ClassLoader 被回收。

- 该类对应的

java.lang.Class对象没有在任何地方被引用,无法在任何地方通过反射访问该类的方法。

引用计数法

引用计数法:每一个对象有一个引用计数器,这个方法实现简单,效率高,但是没有办法解决循环引用问题。

可达性分析

可达性分析:从 GC ROOT 出发,找到所有可达对象;不可达对象就是需要被回收的。

哪些对象可以作为 GC Roots 呢?

- 虚拟机栈(栈帧中的局部变量表)中引用的对象

- 本地方法栈(Native 方法)中引用的对象

- 方法区中类静态属性引用的对象

- 方法区中常量引用的对象

- 所有被同步锁持有的对象

- JNI(Java Native Interface)引用的对象

引用类型

JDK1.2 之前,Java 中引用的定义很传统:如果 reference 类型的数据存储的数值代表的是另一块内存的起始地址,就称这块内存代表一个引用。

JDK1.2 以后,Java 对引用的概念进行了扩充,将引用分为强引用、软引用、弱引用、虚引用四种(引用强度逐渐减弱)。

- 强引用(StrongReference):类似于必不可少的生活用品,平时的引用就是强引用。当内存空间不足,Java 虚拟机宁愿抛出 OutOfMemoryError 错误,使程序异常终止,也不会回收具有强引用的对象来解决内存不足问题。

- 软引用(SoftReference):类似于可有可无的生活用品。如果内存空间足够,垃圾回收器就不会回收它,如果内存空间不足了,就会回收这些对象的内存。只要垃圾回收器没有回收它,该对象就可以被程序使用。软引用可以和一个引用队列(ReferenceQueue)联合使用,如果软引用所引用的对象被垃圾回收,JAVA 虚拟机就会把这个软引用加入到与之关联的引用队列中。

- 弱引用(WeekReference):类似于可有可无的生活用品。弱引用与软引用的区别在于:只具有弱引用的对象拥有更短暂的生命周期。在垃圾回收器线程扫描它所管辖的内存区域的过程中,一旦发现了只具有弱引用的对象,不管当前内存空间足够与否,都会回收它的内存。弱引用可以和一个引用队列(ReferenceQueue)联合使用,如果弱引用所引用的对象被垃圾回收,Java 虚拟机就会把这个弱引用加入到与之关联的引用队列中。

- 虚引用(PhantomReference):虚引用并不会决定对象的生命周期。如果一个对象仅持有虚引用,那么它就和没有任何引用一样,在任何时候都可能被垃圾回收。

虚引用主要用来跟踪对象被垃圾回收的活动。

虚引用与软引用和弱引用的一个区别在于: 虚引用必须和引用队列(ReferenceQueue)联合使用。当垃圾回收器准备回收一个对象时,如果发现它还有虚引用,就会在回收对象的内存之前,把这个虚引用加入到与之关联的引用队列中。程序可以通过判断引用队列中是否已经加入了虚引用,来了解被引用的对象是否将要被垃圾回收。程序如果发现某个虚引用已经被加入到引用队列,那么就可以在所引用的对象的内存被回收之前采取必要的行动。

在程序设计中一般很少使用弱引用与虚引用,使用软引用的情况较多,这是因为软引用可以加速 JVM 对垃圾内存的回收速度,可以维护系统的运行安全,防止内存溢出(OutOfMemory)等问题的产生。

垃圾清扫算法

标记-清除

标记-清除(Mark-and-Sweep)算法分为“标记(Mark)”和“清除(Sweep)”阶段:首先标记出所有不需要回收的对象,在标记完成后统一回收掉所有没有被标记的对象。

这种垃圾收集算法会带来两个明显的问题:

- 效率问题:标记和清除两个过程效率都不高。

- 空间问题:标记清除后会产生大量不连续的内存碎片。

复制

它可以将内存分为大小相同的两块,每次使用其中的一块。当这一块的内存使用完后,就将还存活的对象复制到另一块去,然后再把使用的空间一次清理掉。这样就使每次的内存回收都是对内存区间的一半进行回收。虽然改进了标记-清除算法,但依然存在下面这些问题:

- 可用内存变小:可用内存缩小为原来的一半。

- 不适合老年代:如果存活对象数量比较大,复制性能会变得很差。

标记-整理(标记-压缩)

标记-整理(压缩)算法是根据老年代的特点提出的一种算法,在回收时,让所有存活的对象向一端移动。

由于多了整理这一步,因此效率也不高,适合老年代这种垃圾回收频率不是很高的场景。

分代收集

当前虚拟机的垃圾收集都采用分代收集算法,根据对象存活周期的不同将内存分为几块,不同代采用不同的算法。一般将 Java 堆分为新生代和老年代,这样就可以根据各个年代的特点选择合适的垃圾收集算法。

比如在新生代中,每次收集都会有大量对象死去,所以可以选择”标记-复制“算法,只需要付出少量对象的复制成本就可以完成每次垃圾收集。而老年代的对象存活几率比较高,而且没有额外的空间对它进行分配担保,所以必须选择“标记-清除”或“标记-整理”算法进行垃圾收集。

垃圾收集器

JDK 默认垃圾收集器(使用 java -XX:+PrintCommandLineFlags -version 命令查看):

- JDK 8:Parallel Scavenge(新生代)+ Parallel Old(老年代)

- JDK 9 ~ JDK20: G1

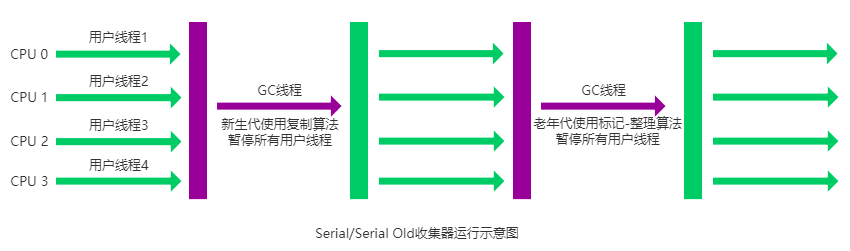

Serial/Serial Old 收集器

Serial 负责新生代,Serial Old 负责老年代。二者都是单线程收集器,在垃圾回收的过程中需要 STW,直到垃圾收集结束。新生代采用标记-复制算法,老年代采用标记-整理算法。

优点:它简单而高效(与其他收集器的单线程相比)。Serial 收集器由于没有线程交互的开销,自然可以获得很高的单线程收集效率。Serial 收集器对于运行在 Client 模式下的虚拟机来说是个不错的选择。

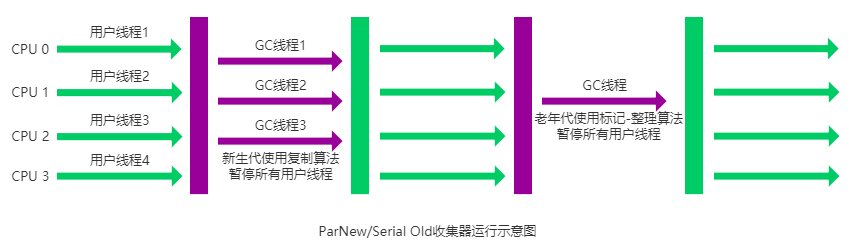

ParNew 收集器

ParNew 是 Serial 收集器的多线程版本。新生代采用标记-复制算法,老年代采用标记-整理算法。

它是许多运行在 Server 模式下的虚拟机的首要选择,除了 Serial 收集器外,只有它能与 CMS 收集器配合工作。

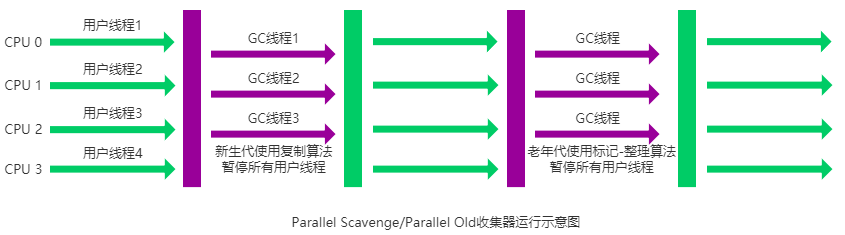

Parallel Scavenge/Parallel Old 收集器

Parallel Scavenge 收集器是负责年轻代的垃圾回收,也是使用标记-复制算法的多线程收集器。Parallel Scavenge 收集器关注点是吞吐量,CMS 等垃圾收集器的关注点更多的是用户线程的停顿时间(提高用户体验)。Parallel Scavenge 收集器提供了很多参数供用户找到最合适的停顿时间或最大吞吐量,如果对于收集器运作不太了解,手工优化存在困难的时候,使用 Parallel Scavenge 收集器配合自适应调节策略,把内存管理优化交给虚拟机去完成也是一个不错的选择。

Parallel Old 是 Parallel Scavenge 收集器的老年代版本。使用多线程和标记-整理算法。

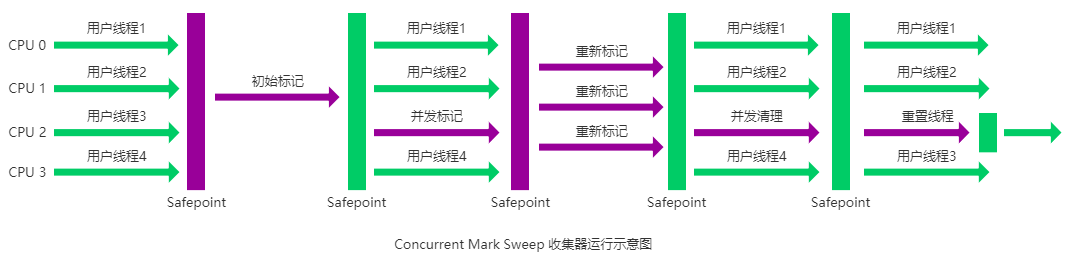

CMS 收集器

CMS 主要关注老年代的对象收集,ParNew 作为年轻代的对象收集配合使用。

CMS(Concurrent Mark Sweep)收集器是一种以获取最短回收停顿时间为目标的收集器。它非常符合在注重用户体验的应用上使用。

CMS(Concurrent Mark Sweep)收集器是 HotSpot 虚拟机第一款真正意义上的并发收集器,它第一次实现了让垃圾收集线程与用户线程(基本上)同时工作。

CMS 收集器是一种标记-清除算法实现的,它的运作过程相比于前面几种垃圾收集器来说更加复杂一些。整个过程分为四个步骤:

- 初始标记: 暂停所有的其他线程,并记录下直接与 root 相连的对象,速度很快 ;

- 并发标记: 同时开启 GC 和用户线程,用一个闭包结构去记录可达对象。但在这个阶段结束,这个闭包结构并不能保证包含当前所有的可达对象。因为用户线程可能会不断的更新引用域,所以 GC 线程无法保证可达性分析的实时性。所以这个算法里会跟踪记录这些发生引用更新的地方。

- 重新标记: 重新标记阶段就是为了修正并发标记期间因为用户程序继续运行而导致标记产生变动的那一部分对象的标记记录,这个阶段的停顿时间一般会比初始标记阶段的时间稍长,远远比并发标记阶段时间短。

- 并发清除: 开启用户线程,同时 GC 线程开始对未标记的区域做清扫。

CMS 在并行标记阶段使用三色标记法+插入和删除写屏障,保证黑色节点不会指向白色节点。

主要优点:并发收集、低停顿。但是它有下面三个明显的缺点:

- 对 CPU 资源敏感;

- 无法处理浮动垃圾;

- 它使用的回收算法-“标记-清除”算法会导致收集结束时会有大量空间碎片产生。

CMS 垃圾回收器在 Java 9 中已经被标记为过时(deprecated),在 JDK 14 被移除。

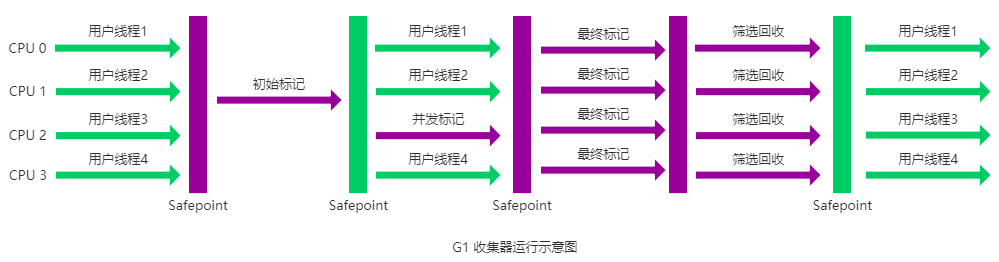

G1 收集器

G1 (Garbage-First) 是一款面向服务器的垃圾收集器,主要针对配备多颗处理器及大容量内存的机器。以极高概率满足 GC 停顿时间要求的同时,还具备高吞吐量性能特征。

它具备以下特点:

- 并行与并发:G1 能充分利用 CPU、多核环境下的硬件优势,使用多个 CPU(CPU 或者 CPU 核心)来缩短 Stop-The-World 停顿时间。部分其他收集器原本需要停顿 Java 线程执行的 GC 动作,G1 收集器仍然可以通过并发的方式让 java 程序继续执行。

- 分代收集:虽然 G1 可以不需要其他收集器配合就能独立管理整个 GC 堆,但是还是保留了分代的概念。

- 空间整合:与 CMS 的“标记-清除”算法不同,G1 从整体来看是基于“标记-整理”算法实现的收集器;从局部上来看是基于“标记-复制”算法实现的。

- 可预测的停顿:这是 G1 相对于 CMS 的另一个大优势,降低停顿时间是 G1 和 CMS 共同的关注点,但 G1 除了追求低停顿外,还能建立可预测的停顿时间模型,能让使用者明确指定在一个长度为 M 毫秒的时间片段内,消耗在垃圾收集上的时间不得超过 N 毫秒。

G1 收集器的运作大致分为以下几个步骤:

- 初始标记

- 并发标记

- 最终标记

- 筛选回收

G1 收集器在后台维护了一个优先列表,每次根据允许的收集时间,优先选择回收价值最大的 Region(这也就是它的名字 Garbage-First 的由来)。这种使用 Region 划分内存空间以及有优先级的区域回收方式,保证了 G1 收集器在有限时间内可以尽可能高的收集效率。

从 JDK9 开始,G1 垃圾收集器成为了默认的垃圾收集器。

ZGC 收集器

ZGC 在 Java 11 引入,处于实验阶段;在 Java15 已经可以正式使用了;在 Java 21 中引入分代 ZGC。